Lee Sedol po raz pierwszy wygrał przeciwko AlphaGo!

Co prawda w czwartej partii z pięciu, a więc już po przegraniu całego meczu, ale jednak.

Komentatorzy twierdzą, że duży wpływ na wygraną mógł mieć fakt, że - przegrawszy mecz - Lee pozbył się z barków ciężaru odpowiedzialności i mógł grać nieco swobodniej.

I zagrał - jak na mistrza przystało - bardzo, bardzo dobrze.

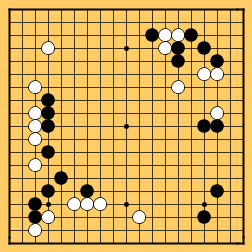

Ponieważ nie znam się zbytnio na Go, muszę polegać na tym, co wyczytałem online. A tam piszą, że po w miarę zrównoważonej grze przez pierwszych 77 ruchów, Lee w 78 ruchu zagrał tesuji. Pojęcie tesuji w Go nie oznacza jakiegoś konkretnego rodzaju ruchu, czy strategii - jest to po prostu bardzo mocny ruch w danej sytuacji, wymagający sporego wysiłku umysłowego (trzeba przewidzieć sporo pozycji "do przodu"). Wykonanie tesuji wymaga mistrzowskiego poziomu oraz lat praktyki.

Żaden z komentatorów oglądających grę na żywo nie zorientował się, że 78 to było tesuji, aż do kilku ruchów później.

Jednak ponieważ plansza w okolicach ruchu 77 była w miarę zrównoważona, a AlphaGo oprócz wiedzy o milionach rozegranych gier ma do swojej dyspozycji również ogromne moce obliczeniowe, powinien był owo tesuji zauważyć.

Niestety (a raczej: stety), nie zauważył. Wczesne teorie mówią, że symulacje Monte Carlo, używane skutecznie do wybrania kolejnego ruchu, w tym konkretnym przypadku były ciut "za krótkie". Ruch 78 sięgał daleko w przyszłość, a także wymagał przeanalizowania jednej, bardzo konkretnej gałęzi drzewa decyzyjnego - w takich przypadkach metoda Monte Carlo zawodzi, ponieważ polega na analizie ogromnej ilości przypadkowych poddrzew decyzyjnych, które siłą rzeczy nie są w stanie pokryć całego zbioru możliwych kontynuacji.

Chwilę potem, jak już okazało się, że ruch 78 był bardzo mocny, pojawia się ciekawostka: począwszy od ruchu 87 aż do 104 AlphaGo wykonuje kilka bardzo słabych ruchów. Tak jakby nagle stracił 3/4 swoich mocy i umiejętności. Tak jakby nie brał pod uwagę, że przeciwnik ma swoją kolej na wykonanie ruchu. I tak dalej.

Potem komputer jakby wraca "na tory", ale wobec przewagi Lee oraz jego perfekcyjnej gry, AlphaGo poddaje się po 180 ruchu.

W poprzednich partiach AlphaGo pozwalał sobie na ruchy nieoptymalne, ale wszystko w ramach wygranej. Innymi słowy wiedząc, że ma przewagę, wolał zwiększyć szansę wygranej o minimalną ilość punktów, zamiast grać nieco mocniej - ale też ryzykowniej - żeby wygrać o więcej punktów. W Go nie ma bowiem bonusów za większą przewagę (wygrana o pół punktu liczy się tak samo, jak wygrana o 20 punktów). Tutaj natomiast, stojąc w obliczu lekkiej przewagi Lee, komputer po prostu zaczął grać słabiej, bez żadnej wyraźnej przyczyny.

Prawdopodobnie wkrótce będzie wiadomo coś więcej, jak już inżynierowie z Google przeanalizują całą rozgrywkę z punktu widzenia maszyny. Póki co skazani jesteśmy jedynie na domysły.

Przypuszczam, że radość Lee nie potrwa długo, ponieważ moc obliczeniowa i "spryt" algorytmów grających są ciągle poprawiane - ale cieszmy się chociaż przez chwilę ze zwycięstwa Galarety nad Metalem.

Hura!

Jeżeli chcesz do komentarza wstawić kod, użyj składni:

[code]

tutaj wstaw swój kod

[/code]

Jeżeli zrobisz literówkę lub zmienisz zdanie, możesz edytować komentarz po jego zatwierdzeniu.