Stan Internetu w 2022 roku jest moim zdaniem opłakany. Dla wielu (większości?) osób nietechnicznych Google == Internet; nawet jeżeli ktoś wie, na jakąś stronę chce zajrzeć, jest całkiem spora szansa, że zamiast otworzyć ją bezpośrednio, wpisze jej nazwę w Google. Zresztą sam tak robię - jeżeli na przykład chcę znaleźć na Wikipedii informacje o Ignacym Krasickim, wpisuję w przeglądarkę "ignacy krasicki wiki" i Google podsuwa mi odpowiedni artykuł z Wikipedii na pierwszym (na ogół) miejscu.

A skoro tak, skoro Google podrzuca nam większość odpowiedzi na nasze pytania, w efekcie często lądujemy zazwyczaj na jednej z 10-15 najpopularniejszych stron. Czasem wręcz wydaje mi się, że współczesny Internet składa się z bardzo małej liczby stron Dużych Dostawców plus parędziesięciu portali względem nich "satelitarnych". Czemu tak jest? Odpowiedź jest banalna: reklamy. Duże portale mają za zadanie tylko jeden cel: przepchnąć przez nasz nerw wzrokowy maksimum reklam, a Google to wykorzystuje.

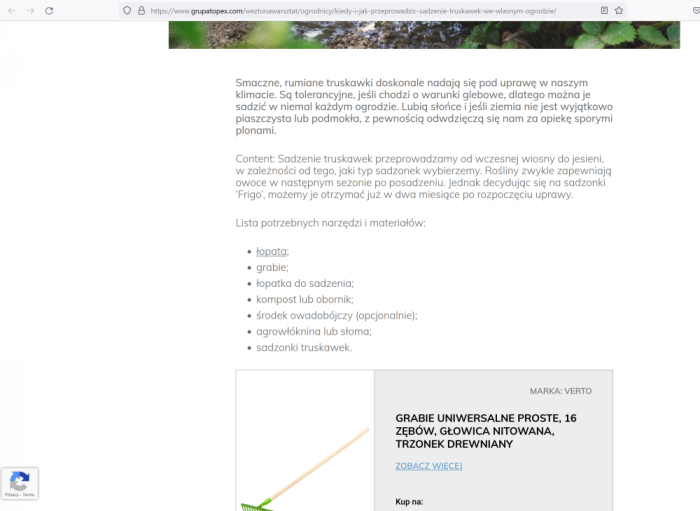

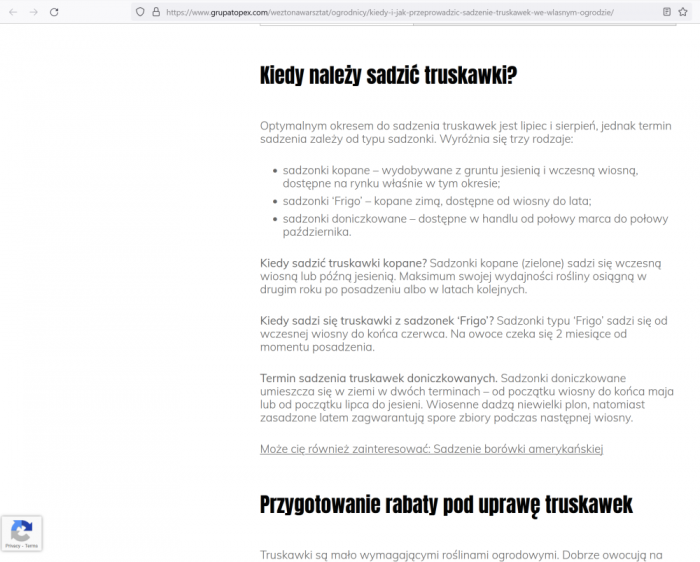

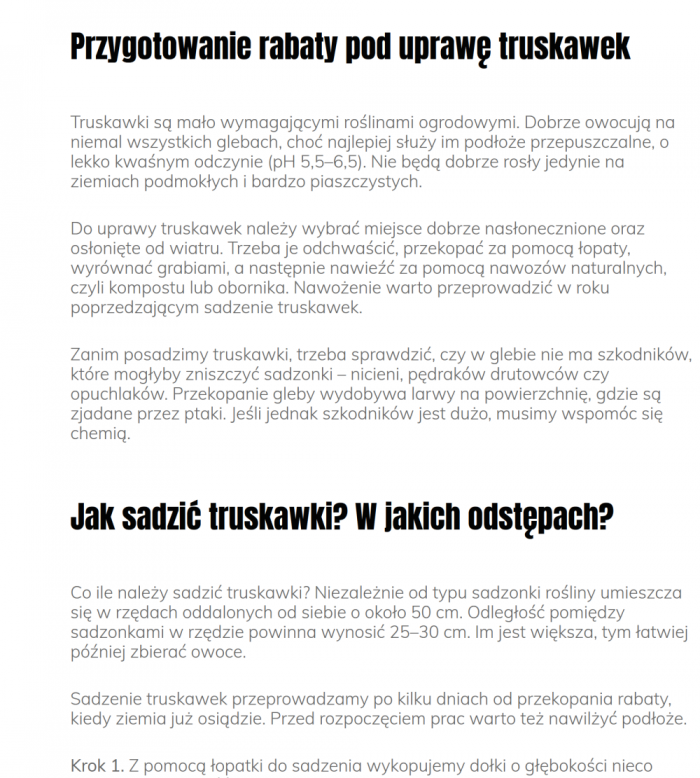

Optymalizacja SEO to całkiem potężna gałąź wiedzy. Jeżeli chcemy, żeby nas czytali, musimy postarać się trafić na pierwszą stronę wyników Google, bo druga i pozostałe nadają się głównie na chowanie zwłok zamordowanego - nikt tam nigdy nie zagląda... Tylko że z tą optymalizacją to jest tak, że Google nagradza strony, na których ludzie pozostają dłużej. Jeżeli więc trafimy na stronę, na której dany temat jest objaśniony na samym początku artykułu, istnieje spora szansa, że to, czego szukamy, przeczytamy od razu i zaraz stronę zamkniemy. Dlatego pełno w wynikach wyszukiwania stron, na których samo gęste zaczyna się poniżej połowy artykułu, często za dolną krawędzią ekranu. Bo najpierw musi być jebitnie wielki obrazek, potem wstęp, rozwinięcie i dopiero samo gęste. Tylko dzięki temu przytrzymamy odwiedzającego dłużej, w efekcie plusując u wielkiego Gie.

Nie wierzysz? No to masz przykłady:

Przykład #1: "Jak sadzić truskawki"

Dawno temu przy rodzinnym domu był ogródek, a w nim - truskawki. Załóżmy że teraz, po latach, naszła mnie ochota na własny ogródek z truskawkami. Sprawdźmy co na ten temat ma do powiedzenia pierwsze trafienie z Google:

Przykład #2: "Alternatywa dla MS Office"

Załóżmy, że jestem w dołku finansowym i szukam oszczędności. Tnę więc subskrypcje jak leci - dochodzę do Office 365 (czy jak tam się to teraz nazywa). Szukam darmowej alternatywy...

Tu musiałem przewinąć "tylko" trzy ekrany, ale i tak zmarnowałem trochę czasu i uwagi na zbędne klamoty. Za każdym razem musiałem też przedrzeć się przez reklamę.

To takie pierwsze z brzegu przykłady - proszę sobie samemu spróbować poszukać odpowiedzi na jakieś pytanie - w większości przypadków zanim dotrzemy do samego gęstego, musimy najpierw przescrollować przez bazylion oczywistości, śmieci i reklam. Wszystko po to, żeby poprawić ingejdżment.

Teraz trochę na plus: Google świetnie radzi sobie z mniej więcej 95% zadań, które mu zlecam. Używam na przykład aplikacji Keep (na smartfonie i na pececie) do robienia szybkich notek (lista zakupów czy co tam) i ewentualnego współdzielenia ich z innymi członkami rodziny. Używam Map, Gmaila, Kalendarza, Androida i wielu innych produktów Google. Działają bardzo dobrze (tak, wiem, jestem produktem, bo "za darmo" to wiadomo, w ryj można dostać) i jestem z nich zadowolony.

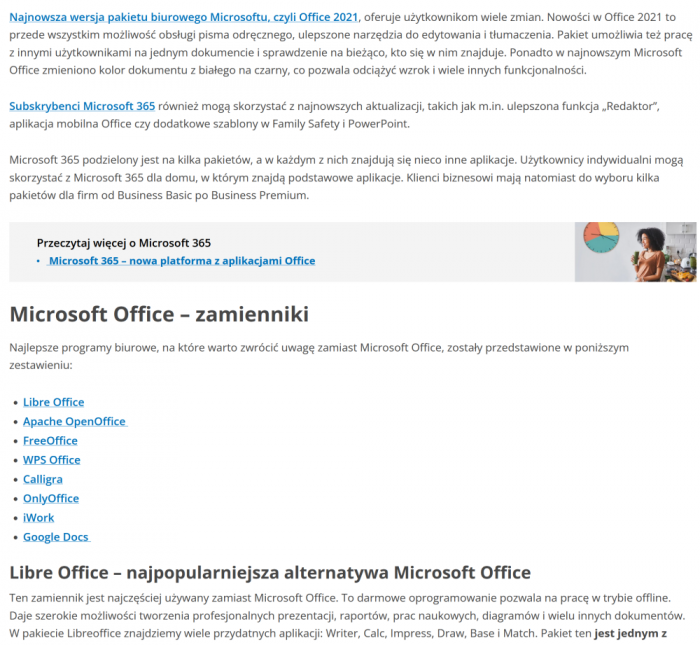

Problem pojawia się na skraju gaussowego dzwona, gdy próbuję znaleźć coś mało popularnego. Na przykład sytuacja, kiedy w jednym z domowych laptopów nagle tajemniczo "znika" moduł Bluetooth.

Oczywiście wyniki wyszukiwania wszystkie jak jeden mąż prowadzą do stron tłumaczących jak sparować urządzenie Bluetooth, jak włączyć / wyłączyć funkcję Bluetooth w Windows i tak dalej. Nigdzie nie ma ani słowa o tym co zrobić kiedy funkcjonalność Bluetooth znika z naszego laptopa kompletnie. Dopiero gdzieś na ochnastej stronie wyników udało mi się trafić w link do jakiegoś użytkownika na Reddit, który miał dokładnie ten sam problem i znalazł rozwiązanie.

Kolejny problem, jaki mam z Google, to jak bardzo zakłamani są w kwestii porad jak pisać, żeby być lepiej znalezionym. Jest oczywiście milion stron z poradnikami jak poprawić swoje SEO, ale temat sprowadza się tak naprawdę do jednego: pisz ciekawie, oryginalnie i zajmująco. Bo różne "brudne" tricki umożliwiające tanim kosztem wspięcie się na szczyt pierwszej strony wyników Google już zna od dawna i umie sobie z nimi radzić (lepiej lub gorzej, ale zawsze).

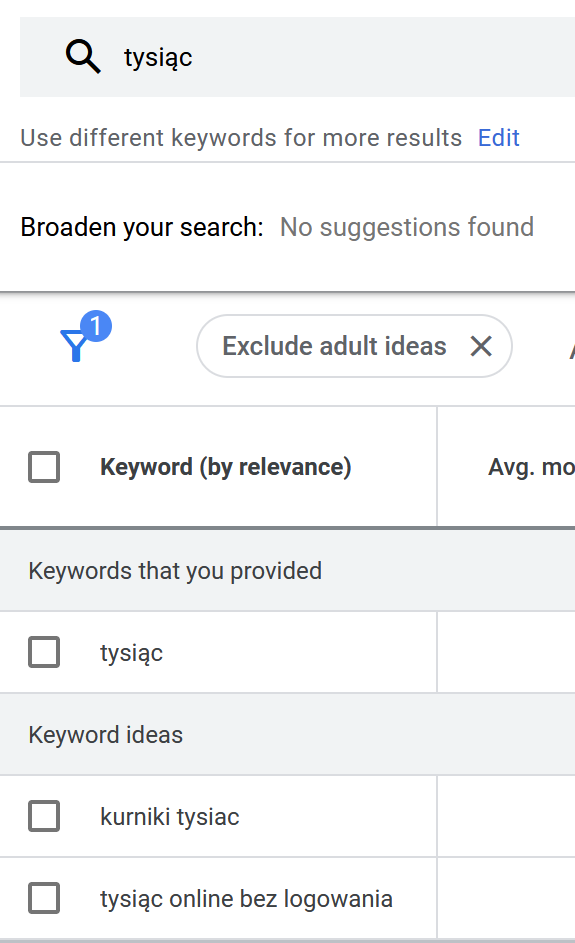

Ale jak sobie zajrzymy w konsolę AdWords, zobaczymy, że dla danego słowa kluczowego Google natychmiast sugeruje nam jakie inne słowa powinny wystąpić w okolicy, żeby poprawić pozycję w wynikach wyszukiwania. Przykładowo, sprawdźmy słowo "tysiąc":

Wychodzi na to, że pisząc o grze w tysiąca najlepiej wspomnieć o kurniku albo o wersji online.

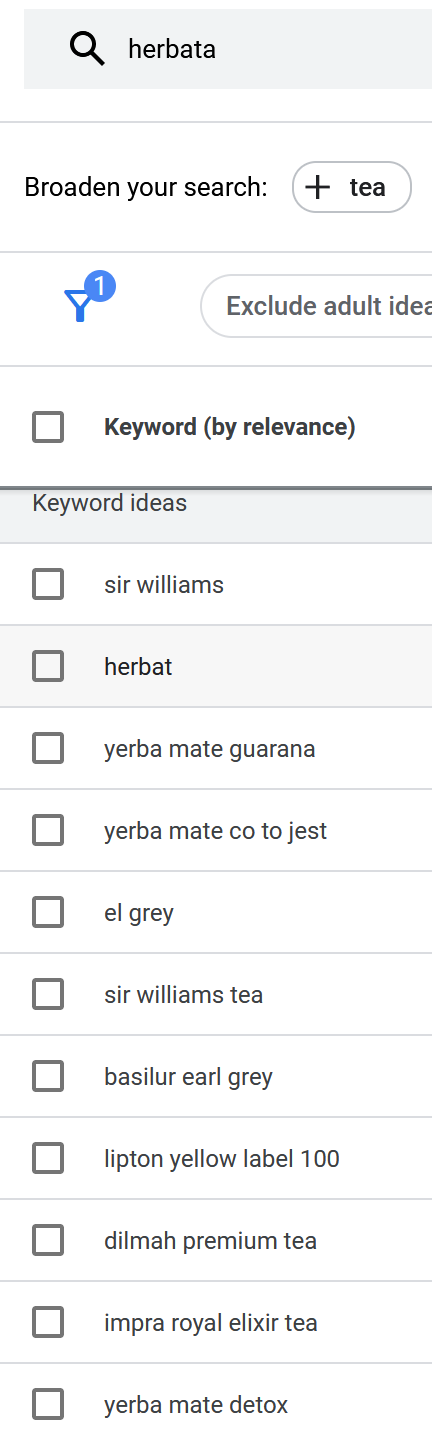

Spróbujmy z herbatą:

Aha, czyli najlepiej będą wypozycjonowane strony, które piszą o herbacie yerba mate, sir williams albo lipton.

A skąd w ogóle biorą się te grupy ("klastry") słów? Oczywiście z ich popularności w Sieci. Czym częściej ktoś pisze o herbacie yerba mate, czym chętniej Google będzie promował inne strony, na których "herbata" i "yerba mate" pojawią się po sąsiedzku.

I tak dalej, i tak dalej. Problem jest tak oczywisty, że aż boli: częściej będą w wynikach wyszukiwania pojawiać się strony, które używają najpopularniejszych zestawów słów. Dlatego czytanie artykułów w dzisiejszej Sieci daje nam wrażenie, że wszystko jest do wszystkiego podobne i trudno znaleźć coś oryginalnego. Google popiera sztampowe pisanie!

Pójdźmy jednak nieco dalej. Na razie pokazałem, że Google nagradza twórców, którzy potrafią przyciągnąć czytelnika na dłużej, głównie przez umieszczanie wartościowej informacji na dole strony, żeby czytelnik musiał przekopać się przez tonę mułu zanim znajdzie to, czego szukał. Pokazałem też, że porady o tym, aby pisać niesztampowo i oryginalnie aby poprawić swoje wyniki można sobie włożyć w tyłek. Ale to nie jedyne sposoby, w jakie Google "karze" twórców siedzących na krawędzi gaussowego dzwona.

Wyobraźmy sobie, że napisaliśmy przed chwilą najlepszy, najbardziej dopracowany, atrakcyjny wizualnie i merytorycznie artykuł na jakiś chwytliwy temat. Nie wiem, coś o gaciach jakiejś popularnej gwiazdki pop albo o szczepionkach, albo o występach kabareciarzy. Temat w każdym razie chwytliwy, będzie szedł jak świeże bułki.

Załóżmy też, że bardzo podobny artykuł napisał na swoim blogu kolega (albo konkurent) o profilu zbliżonym do naszego. Zadziwiająco dobrał takie same słowa kluczowe, utrzymał treść w podobnym tonie i stylu i tak dalej.

Okazuje się, że jeżeli na naszej stronie znajduje się więcej słabo spozycjonowanych artykułów niż u konkurencji, konkurencja zostanie "nagrodzona" wyższym miejscem w wynikach wyszukiwania.

A także: jeżeli w naszym artykule znajdują się linki do stron mniej popularnych niż u konkurencji, konkurencja również zostanie nagrodzona.

Trochę to dziwne: żeby podbić popularność własnego artykułu, muszę (A) skasować inne, mniej popularne artykuły na własnej stronie albo (B) linkować do bardziej popularnych miejsc. A+B daje w wyniku spiralę śmierci, w której najpopularniejsze artykuły trafiają na szczyty wyszukiwarek nie dlatego, że są fajnie napisane, tylko dlatego, że są popularne.

Trochę jak z celebrytami: są znani głównie z tego, że są znani...

Kolejna sprawa, która mnie męczy w popularnych wyszukiwarkach, to jak bardzo unikają one konkretów. No bo skoro dla większości społeczeństwa Internet == Google, to jeżeli w wyniku wyszukiwania pojawi się fałszywa informacja, winą obarczą przecież wyszukiwarkę, a nie tego, kto tę informację w Sieci umieścił. Dlatego jeżeli wpiszemy w Google, dajmy na to, "najlepszy laptop", to zamiast listy najlepszych laptopów dostaniemy listę stron, które prezentują rankingi laptopów. Dzięki temu odpowiedzialność za ewentualny zawód czytelnika, że najlepszy laptop jednak nie jest taki najlepszy zostaje przeniesiona na kogoś innego.

Oczywiście zamiast laptopa można szukać roweru, książki czy maści na porost włosów, reguła pozostaje w mocy. Swoją drogą określenie "nalepszy X" jest debilne, bo bez znajomości kryteriów owej "najlepszości" można sobie co najwyżej podłubać w... w nosie, dajmy na to.

Problemy z wyszukiwarkami dotyczą nie tylko Google. Taki Bing na przykład wydaje się promować linki do stron popularnych na FB czy Twitterze, co ma tę wadę, że są one tak czy siak łatwie do znalezienia o ile ktoś używa danej sieci społecznościowej, czyli znów spirala popularności zamiat promowania treści oryginalnych.

Co można z tym zrobić?

Wydaje mi się, że nie za wiele. Dopóki te 95% wyników wyszukiwania się sprawdza, ludzie nie mają inicjatywy, żeby przechodzić z popularnych wyszukiwarek na inne, mniej znane.

Ja osobiście robię tak, że jeżeli nie mogę czegoś mało popularnego znaleźć w Google, odpalam Qwant, DDG albo Ecosię (ta ostatnia na przykład daje mi odpowiedź na znikającego Bluetootha już na pierwszej stronie wyników - może nie na samej górze, ale blisko) i wtedy - na ogół, bo nie zawsze - udaje mi się problem rozwiązać.

Skąd się to bierze?

Niezależni, mało znani twórcy wyszukiwarek nie mają na ogół targetów reklamowych, nie podlegają też presji społecznej żeby dostarczać wyników zgodnych z Dyrektywą Główną - w efekcie mogą sobie pozwolić na eksperymenty i więcej swobody w implementowaniu algorytmu wyszukiwania, docelowo dostarczając wyników relewantnych to tego, czego faktycznie szukamy, zamiast pchać nam w gałki oczne tony reklam.

Konkluzja z tego przydługiego bełkotu?

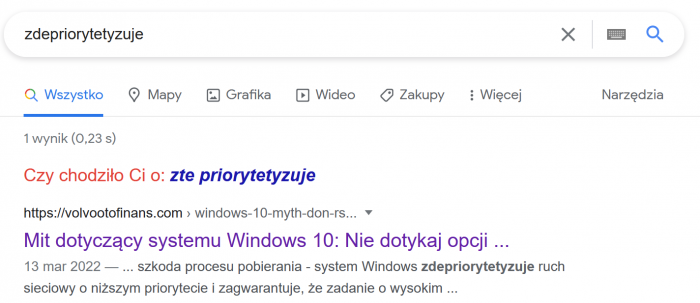

Moim cichym marzeniem jest dostęp do takiej wyszukiwarki, która zdepriorytetyzuje (uff, dużo sylab) wielkie portale pełne reklam lub czające się za paywallem, a da więcej głosu twórcom indywidualnym. Oczywiście to mrzonka, całkiem jak oddanie władzy w ręce ludu - jak pokazuje historia na ogół działanie takie kończy się krwawą jatką i ogłoszeniem nowego despoty - ale pomarzyć sobie chyba można 🙂

P.S. Ciekawostka:

Słowo "zdepriorytetyzuje" w polszczyźnie nie istnieje, ale najwyraźniej ktoś go już wcześniej użył.

Bardzo fajna notka. Nic mądrego nie powiem, ale wyrażę zdziwienie, że pod koniec nie wymieniłeś DuckDuckGo wśród propozycji alternatywnych przeglądarek. Ja mam ustawioną DGG domyślnie w pasku adresowym, ale powiem jak na spowiedzi, że często poprzedzam frazę do wyszukania bangiem g, aby DGG przekierował zapytanie do G — ponieważ domyślam się, że Gugiel poradzi sobie z rzeczonym zapytaniem lepiej od Kaczki.

Na marginesie: Chciałbym, żeby powstał agregator do blogów niekomercyjnych na tematy różne, kulturalno-techniczno-prywatne, takie jak Twój, mój, Kowalstwo Obłoków, Cichy Fragles, Szczeżuja… Bo w dzisiejszych czasach bardzo trudno takie zakątki w Sieci wyszukać samodzielnie lub natrafić na nie przypadkowo.

DDG używam w większości miejsc jako podstawowej wyszukiwarki od wielu lat. Nie to, że wszędzie, albo że nie zdarza mi się z premedytacją użyć Google. I o ile daje się używać, to mam wrażenie, że to po prostu inny bąbel.

Co do agregatora – jak chcesz, to zrób, to nie jest problem przecież? Nie technicznie, przynajmniej. Tu masz gotowca https://github.com/rozie/PlanetJogger z którego działa https://zakr.es/planetjogger/about.html Zresztą, technicznie to mogę się tym zająć (a zyskami z reklam się podzielimy, hrhr…). Problemem jest co innego – zawartość. Trzeba znaleźć treści, które chcesz mieć na blogu, pogadać z autorami w celu uzyskania zgody. Bo smutna prawda wynikająca z moich doświadczeń jest taka, że samodzielnie dodać się będą chcieli jedynie spamerzy^Wspecjaliści SEO.

Inna rzecz, że miałem wrażenie, że rolę takiej wyszukiwarki zakątków miał pełnić Mastodon. Tyle, że IMO średnio mu to wychodzi.

Dawno se miałem zrobić agregator do blogów itp. (z 15 lat temu ćwiczyłem, jak było więcej blogów do agregowania…), ale dopóki nie mam AI pod ręką 😉 jest problem na poziomie meta- kto „czyta” i decyduje o agregacji.

Bo jeśli zwykłym chamskim algo po linkach, „cytowaniach” i popularnościach, to jedynym zyskiem byłoby jakieś wycięcie stron clickbaitowo-„przereklamowanych”, i sam fakt, że algo lepsze niż gugla czy binga, bo MOJE! 😉

Jeśli w modelu „peer review”, tj. wg mojej/czyjejś oceny meta i merytorycznej, no to nie jest auto- wyszukiwarka czy agregator, ale „moja/nasza lista polecanek”, zupełnie jak w kącie bloga, ew. coś jak prehistoryczne listy linków na BBSach sprzed epoki http://WWW... Działa(ło), jeśli mnóstwo zaufanych ludzi to maintainuje, ciągle, właśnie niczym system „peer review” w nauce czy inną wikipedię itp. A nawet znacznie trudniej, bo przecież fajna strona/blog dziś, może być badziewiem za tydzień, to nie „zamrożona” publikacja naukowa czy niezbyt dynamiczna encyklopedia.

Jeśli agregacja przez samo-dodawanie, czy ocenę przez „społeczność”, no to fejsa już mamy (znaczy, macie), oraz przegram z algo/farmami spamerów i reklamodawców, zaraz po wystawieniu głowy poza lokalny grajdołek, łan-tu-tri.

BTW Mastodona itp. – trzeba by odróżniać federation od aggregation, Mastodon celował, zdaje się w to pierwsze. Zresztą, kiedyś WordPress też tak celował. Wyszukiwarki nurkujące w „całej sieci” to jednak drugie.

A notka zacna, również moje wrażenia z netu 2022.

Agregator nie był dla mnie problemem. Problemem bardziej były deduplikator i selektor. Bowiem feedy dzielę na dwa rodzaje: te, których jest za mało i ciężko je znaleźć. Zwykle oldschoolowe blogi, z niewielką liczbą publikacji. Rzadko dotyczą spraw bieżących. I drugi rodzaj: feedy z newsami. Często powielające zawartość z innych feedów, raczej za dużo artykułów i raczej chcę przeczytać tylko część z nich. Te drugie zjadają czas, który mógłbym poświęcić na czytanie tych pierwszych. Ale trochę ciężko z nich zrezygnować.

Nawet przymierzałem się do automatu, prostego na początek. Przejrzeć 1-2 strony z Hacker News, wyłuskać linki, wybrać tytuły i keywords, znormalizować. Potem można się bawić w „AI” (bardziej: ML), choć na początek pewnie i proste reguły a’la regexp i budowanie score (wzorem NNTP) by wystarczyły. Niestety, wyszło mi, że to nie jest takie do końca trywialne. Wielka jest wena w tworzeniu keywordów i tytułów, pewnie trzeba by brać pod uwagę tagi, różne silniki blogów itp. Albo i parsować i autotagować treść. BTDT, nawet nieźle to ostatnie działało dla moich wpisów (tylko polski, dużo wyjątków), a teraz są różności do rozpoznawania tekstu, więc pewnie da się łatwiej.

Ale to nadal nie do końca rozwiąże sprawę, bo następnego dnia pojawią się polskie „przedruki”. A reguły/scoring trzeba utrzymywać, silnik też. No i trochę ryzyko, skończę w bąbelku z duplikatami o tym samym, napisanych różnym językiem/w różnych językach. To już może lepiej przejrzeć wszystkie tytuły?

I teraz w kontekście Mastodona: owszem, federation. Tylko jakby miało być, że tu będzie ten niekomercyjny, nieskażony algorytmami wielki social media content i będzie można sobie wybrać. I po nitce do kłębka. Tak, trochę taka polecanka ręczna. Ktoś pisze ciekawie/linkuje interesujące rzeczy to zobaczę, kogo obserwuje, pewnie też ciekawe konta. Nic nowego, miałem o tym notkę https://zakr.es/blog/2010/08/jak-znalezc-znajomych-na-twitterze-identi-ca/

Z wielu powodów to nie działa. Konto X może być dla mnie ciekawe, bo 80% contentu mnie interesuje, ale właściciel może interesować się jeszcze N innymi tematami, które mnie nie interesują i mieć tego typu konta w obserwowanych. Dalej: niewspomagane przeglądanie kont, przy braku notyfikacji o zaobserwowaniu/odobserowaniu jest czasochłonne. No i zmienność jakości konta w czasie czyli „fajne konto dziś może być badziewiem za tydzień” (i w drugą stronę). Nie żebym uważał, że oczekiwania AKA zapotrzebowanie na content po stronie odbiorcy były stałe.

„wyrażę zdziwienie, że pod koniec nie wymieniłeś DuckDuckGo wśród propozycji alternatywnych przeglądarek”

(a) wyszukiwarek nie przeglądarek, (b) wymieniłem, zerknij jeszcze raz. Aha, jeszcze (c): DDG „podpiera się” od dość dawna Bingiem, więc są tak naprawdę słabi.

To samo chciałam napisać. Ponieważ Borysie zrobiłeś. Tylko się popiszę, podpiszę. Miłego dnia.

Rozpisane dosyć szczegółowo, że dziś WWW to miejsce, gdzie wszystko jest produktem i walka toczy się o to jak to sprzedać.

Także i wyszukiwarka nie wyszukuje informacji, tylko potencjalnych transakcji (co nam sprzedać).

I od tego ucieczki już nie ma, bo duzi gracze konstruują kierunek rozwoju WWW właśnie w tym kierunku.